Estados Unidos ha descubierto de golpe que la supremacía de las compañías que entrenan grandes modelos de lenguaje de inteligencia artificial está amenazada por los avances de la empresa china DeepSeek, que ha creado un modelo de IA capaz de rivalizar y de superar en pruebas objetivas a los estadounidenses más punteros con un coste de entrenamiento 50 veces menor. ¿Cómo ha conseguido esto una empresa china frente a gigantes como OpenAI/Microsoft, Google o Meta entre otros? Probablemente una parte de la culpa la tenga el propio Gobierno federal norteamericano.

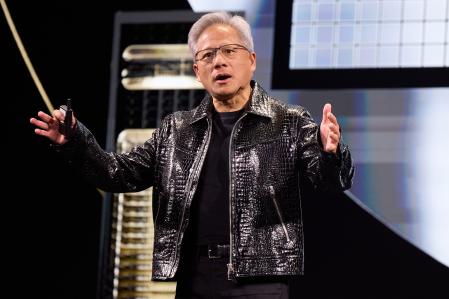

El consejero delegado de Nvidia, Jensen Huang,el pasado enero en la feria Consumer Electronic Show (CES) de Las Vegas

Lo que DeepSeek ha demostrado es que los grandes modelos de lenguaje pueden entrenarse de forma mucho más eficiente sin llegar a utilizar los chips especializados de Nvidia para la inteligencia artificial, lo que ha provocado hoy su gran batacazo en la bolsa. En una analogía del profesor de psicología cognitiva Gary Marcus, esta compañía se ha enriquecido vendiendo palas, muy bien diseñadas, en medio de la fiebre del oro de la IA. Y ahora resulta que quizás no hacen falta estas sofisticadas y costosas palas.

La gran pregunta es cómo ha llegado DeepSeek a igualar los resultados de las grandes de Estados Unidos sin el acceso a los chips de Nvidia. En agosto del 2023, el ejecutivo de Joe Biden impulsó la llamada ley CHIPS para estimular la fabricación de chips en territorio estadounidense y el cierre de la frontera tecnológica con China. Es precisamente esa falta de acceso a los chips para IA más avanzados de EE.UU. mediante un control de exportaciones lo que ha llevado a la empresa china a buscar un enfoque que le permita alcanzar resultados similares aunque a un coste muchísimo menor. Para colmo, DeepSeek empezó a trabajar con el modelo Llama de Meta, que fue puesto en código abierto.

Esta realidad parece pillar a las grandes tecnológicas de Estados Unidos con el paso cambiado. Es evidente que disponer de chips de altas capacidades va a seguir siendo necesario, pero el discurso sobre los grandes macrocentros de datos con inversiones multimillonarias de las que no se conoce el detalle (medio billón cuesta el proyecto Stargate, con OpenAI, Microsoft, Nvidia, Oracle y SoftBank) puede quedar seriamente sacudido. A Elon Musk también le pilla a contrapié. El año pasado construyó uno de esos macrocentros en Memphis (Tennessee) para la IA de la red social X. Todo con chips de Nvidia. Y ahora pensaba duplicarlo todo.

En términos estrictamente técnicos, las tecnológicas estadounidenses van a seguir avanzando en sus nuevos modelos, aunque ya se expresan dudas en el sector sobre si el enfoque de ir agrandando los modelos va a proporcionar ventajas significativas en el futuro (y a superar los fallos, las llamadas alucinaciones) o si hay que emplear las grandes inversiones en nuevos enfoques. Por otro lado, el desarrollo de la IA en China nos trae una nueva realidad. Pregúntenle al modelo chino por la masacre de Tiananmen o por la independencia de Taiwan. Se hace el sordo.